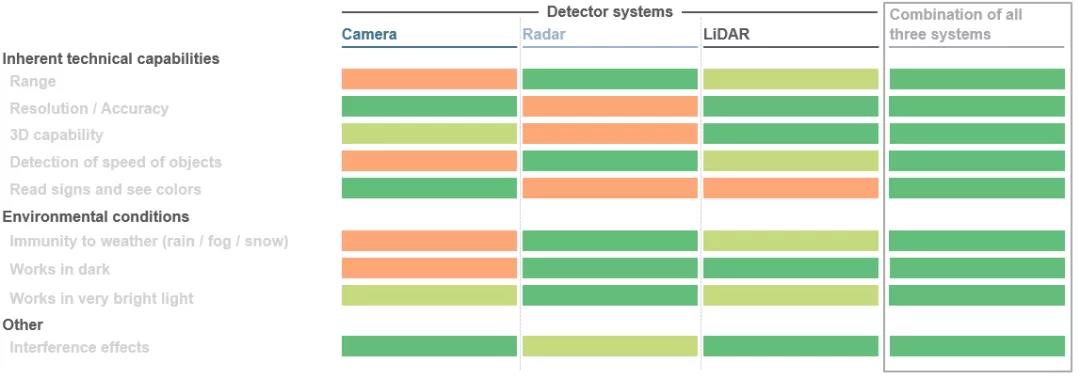

Der sker et kæmpe spring inden for mobilitet. Dette gælder, uanset om det er i bilsektoren, hvor løsninger til autonom kørsel udvikles, eller i industrielle applikationer, der anvender robotteknologi og automatiserede vejledte køretøjer. De forskellige komponenter i hele systemet skal samarbejde med hinanden og supplere hinanden. Hovedmålet er at skabe en sømløs 3D-visning rundt om køretøjet, bruge dette billede til at beregne objektafstande og igangsætte køretøjets næste bevægelse ved hjælp af specielle algoritmer. Faktisk bruges tre sensorteknologier på samme tid her: LiDAR (LiDAR), radar og kameraer. Afhængigt af det specifikke anvendelsesscenarie har disse tre sensorer deres egne fordele. At kombinere disse fordele med redundante data kan forbedre sikkerheden markant. Jo bedre disse aspekter er koordineret, jo bedre vil den selvkørende bil være i stand til at navigere i sine omgivelser.

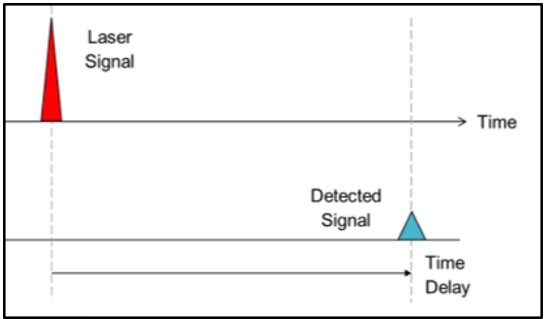

1. Direkte flyvetidspunkt (dToF):

I time-of-flight tilgangen bruger systemproducenter lysets hastighed til at generere dybdeinformation. Kort fortalt skydes rettede lysimpulser ud i omgivelserne, og når lysimpulsen rammer en genstand, reflekteres den og optages af en detektor nær lyskilden. Ved at måle den tid, det tager for strålen at nå objektet og returnere, kan objektafstanden bestemmes, mens man i dToF-metoden kan bestemme afstanden af en enkelt pixel. De modtagne signaler behandles til sidst for at udløse tilsvarende handlinger, såsom undvigelsesmanøvrer for at undgå kollisioner med fodgængere eller forhindringer. Denne metode kaldes direkte time-of-flight (dToF), fordi den er relateret til den nøjagtige "time-of-flight" af strålen. LiDAR-systemer til autonome køretøjer er et typisk eksempel på dToF-applikationer.

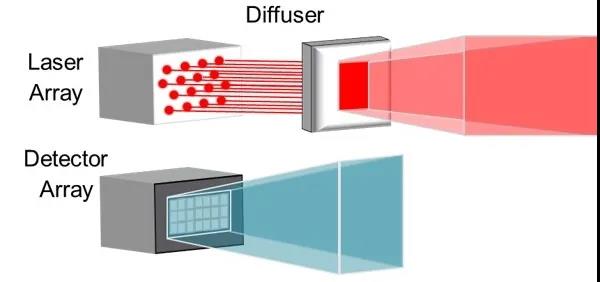

2. Indirekte flyvningstid (iToF):

Den indirekte time-of-flight-tilgang (iToF) er ens, men med en bemærkelsesværdig forskel. Belysning fra en lyskilde (normalt en infrarød VCSEL) forstærkes af et undvigende ark, og impulser (50 % duty cycle) udsendes til et defineret synsfelt.

I nedstrømssystemet vil et lagret "standardsignal" udløse detektoren i en periode, hvis lyset ikke støder på en forhindring. Hvis et objekt afbryder dette standardsignal, kan systemet bestemme dybdeinformationen for hver defineret pixel i detektoren baseret på det resulterende faseskift og tidsforsinkelsen af pulstoget.

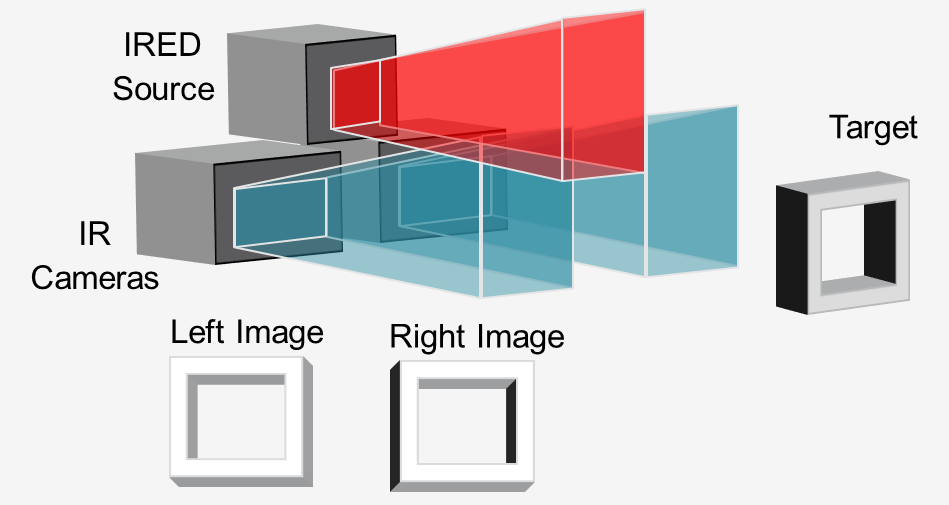

3. Active Stereo Vision (ASV)

I "aktiv stereovision"-metoden oplyser en infrarød lyskilde (normalt en VCSEL eller IRED) scenen med et mønster, og to infrarøde kameraer optager billedet i stereo.

Ved at sammenligne de to billeder kan downstream-software beregne den nødvendige dybdeinformation. Lys understøtter dybdeberegninger ved at projicere et mønster, selv på genstande med lidt tekstur, såsom vægge, gulve og borde. Denne tilgang er ideel til 3D-sansning på nært hold i høj opløsning på robotter og automatiske guidede køretøjer (AGV'er) for at undgå forhindringer.

Copyright @ 2020 Shenzhen Box Optronics Technology Co., Ltd. - Kina fiberoptiske moduler, fiberkoblede laserproducenter, leverandører af laserkomponenter Alle rettigheder forbeholdes.